Ta strona korzysta z plików cookie, aby poprawić Twoje doświadczenia. Zakładamy, że się z tym zgadzasz, ale możesz zrezygnować, jeśli chcesz. Czytaj więcej

Web Scraping

Efektywny scraping danych z każdej strony internetowej, przekształcając je w wartościowe informacje. U nas dostaniesz tylko dokładne i aktualne dane.

Pobieranie danych z internetu dla rozwoju twojego biznesu

Kilka przykładowych branż dla których świadczymy usługi ekstrakcji danych.

Monitorowanie cen konkurencji

Monitorowanie cen konkurencji pozwala na bieżące śledzenie zmian cenowych w branży. Dzięki temu można szybko dostosowywać własne ceny, aby pozostać konkurencyjnym i przyciągać więcej klientów. To rozwiązanie umożliwia strategiczne zarządzanie polityką cenową.

Pobieranie produktów

Pobieranie produktów z różnych źródeł internetowych umożliwia łatwe budowanie obszernej bazy produktowej. Dzięki temu można szybko zaimportować pełne katalogi produktów do sklepu internetowego, co pozwala na szybsze rozszerzenie oferty. Ta usługa zapewnia również aktualizację produktów i oszczędza czas.

Pobieranie opinij o produktach

Pobieranie opinii o produktach z różnych źródeł pozwala na lepsze zrozumienie potrzeb i oczekiwań klientów. Te cenne informacje mogą być zaimportowane do sklepu internetowego, co pomaga w budowaniu zaufania i zwiększaniu sprzedaży. Dzięki temu możliwe jest również szybsze reagowanie na ewentualne problemy i poprawa oferty.

Analiza Wynagrodzeń

Pozyskiwanie danych dotyczących wynagrodzeń z ogłoszeń o pracę umożliwia firmom i kandydatom na dokładne zrozumienie rynkowych stawek płac. Analiza tych danych pozwala firmom na konkurencyjne ustalanie wynagrodzeń, a kandydatom na realistyczne oczekiwania finansowe.

Optymalizacja Procesu Rekrutacji

Dzięki web scrapingowi można automatyzować proces zbierania i analizowania aplikacji, co znacząco przyspiesza proces rekrutacji. Agencje rekrutacyjne mogą szybciej przesiewać aplikacje i identyfikować najbardziej odpowiednich kandydatów, co zwiększa efektywność całego procesu.

Monitorowanie Ofert Pracy

Web scraping pozwala na automatyczne zbieranie ofert pracy z różnych portali rekrutacyjnych, stron firmowych oraz platform społecznościowych. Dzięki temu agencje rekrutacyjne i firmy mogą na bieżąco śledzić nowe oferty, analizować trendy i szybko reagować na zmieniające się potrzeby rynku.

Identyfikacja Potencjalnych Inwestycji

Automatyczne pozyskiwanie danych o nowych projektach deweloperskich i inwestycjach w infrastrukturę pozwala na szybkie zidentyfikowanie potencjalnych okazji inwestycyjnych. To narzędzie wspiera deweloperów i inwestorów w podejmowaniu decyzji o nowych projektach i ekspansji na nowe rynki.

Monitorowanie cen na nieruchomości

Pozyskiwanie danych o cenach nieruchomości z wielu źródeł pozwala na dokładną analizę trendów cenowych w różnych regionach. To narzędzie pomaga agencjom i deweloperom w ustalaniu konkurencyjnych cen, a także w identyfikowaniu najbardziej atrakcyjnych lokalizacji dla inwestycji.

Monitorowanie ogłoszeń nireuchomości

Web scraping umożliwia automatyczne zbieranie ogłoszeń o sprzedaży i wynajmie nieruchomości z różnych portali internetowych. Dzięki temu agencje nieruchomości mogą na bieżąco śledzić nowe oferty, analizować trendy rynkowe i szybko reagować na zmiany w popycie i podaży.

Badania naukowe

Web scraping może być używany do zbierania danych do celów badawczych, takich jak analiza dużych zbiorów danych czy monitorowanie literatury naukowej. To narzędzie pozwala naukowcom na efektywne gromadzenie i analizowanie danych potrzebnych do prowadzenia badań i publikowania wyników.

Analiza trendów edukacji

Pozyskiwanie danych z blogów, forów i artykułów branżowych pozwala na monitorowanie najnowszych trendów w edukacji. Szkoły i instytucje edukacyjne mogą dzięki temu dostosowywać swoje programy i metody nauczania do aktualnych oczekiwań i potrzeb studentów.

Monitorowanie opinii studentów

Pozyskiwanie danych z portali recenzujących i media społecznościowe pozwala na monitorowanie opinii studentów o kursach, profesorach i instytucjach edukacyjnych. To cenne informacje, które mogą być wykorzystane do poprawy jakości kształcenia i zarządzania reputacją uczelni.

Powyżej przedstawiliśmy jedynie przykłady danych, które możemy dla Ciebie pozyskać. Skontaktuj się z nami, aby omówić Twój projekt.

Dlaczego skutecznie pozyskujemy dane?

Skutecznie pozyskujemy dane dzięki zaawansowanym technologiom, doświadczeniu i elastycznym rozwiązaniom dostosowanym do indywidualnych potrzeb naszych klientów.

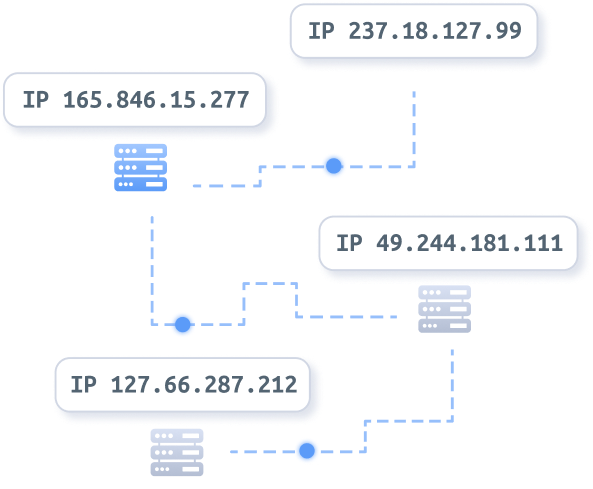

Infrastruktura Proxy

Automatyczna

zmiana adresów IP

- Adresy IP z ponad 195 krajów

- 100% prywatność

- Nielimitowana przepustowość

Rozwiazanie Captcha

Wypracowaliśmy sposoby na rozwiązywania CAPTCHy

Przegladarka

Symulacja prawdziwej przeglądarki w sieci

Własne serwery

Posiadamy własną infrastrukturę serwerową

PROgramiści

Zespół profesjonalnych programistów pod ręką

Gotowe rozwiązania

Dzięki wieloletniemu doświadczeniu

wypracowaliśmy sporo gotowych rozwiazań

- Szeroka baza danych kontaktowych

- Rozwiazania do własnego zarządzania scrapingiem

- Dużo gotowych scraperów

Pobieranie danych ze strony do Excela

Przygotowane pliki są najczęściej pobierane w formatach XLSX, XLS, CSV, JSON, XML, SQL.

Żródła danych

Pozyskujemy dane z różnorodnych źródeł, takich jak sklepy internetowe, portale ogłoszeniowe, media społecznościowe, strony z recenzjami itp.

- https://bid.cars/pl/

BID.CARS

- https://extradom.pl

Extradom

- https://pepper.pl

Pepper

- https://gratka.pl

Gratka

- https://booksy.com

Booksy

- https://twitter.com

- https://youtube.com

YouTube

- https://instagram.com

- https://facebook.com

- https://ubuy.com

uBuy.com

- https://pocztakwiatowa.pl

Poczta Kwiatowa

- https://cars.com

cars

Proces współpracy przy ekstrakcji danych

Ustalenie żródła i ilości danych

Współpracę rozpoczynamy od dokładnego ustalenia, jakie źródła danych są dla Ciebie kluczowe. Określamy również, jaką ilość danych potrzebujesz i jakie konkretne informacje mają być pozyskane. To pozwala nam na precyzyjne dostosowanie naszych usług do Twoich wymagań.

Analiza witryny i szacowany koszt

Następnie przeprowadzamy szczegółową analizę wybranej witryny, aby ocenić stopień trudności i czasochłonność zadania. Na podstawie analizy przedstawiamy szacunkowy koszt realizacji projektu. Transparentność wycen pozwala na pełne zrozumienie inwestycji z Twojej strony.

Stworzenie scrapera i pobieranie danych

Po zaakceptowaniu warunków przystępujemy do tworzenia dedykowanego scrapera, dostosowanego do specyfiki witryny. Nasze narzędzia są zaprojektowane, aby szybko i efektywnie pozyskiwać dane. Proces pobierania danych jest monitorowany, aby zapewnić najwyższą jakość.

Weryfikacja danych i rozliczenie

Po zakończeniu ekstrakcji, przeprowadzamy szczegółową weryfikację pozyskanych danych, aby zapewnić ich dokładność i spójność. Po zakończonej weryfikacji przedstawiamy wyniki oraz rozliczamy się zgodnie z ustaleniami. Gwarantujemy pełną satysfakcję z dostarczonych usług oraz przejrzystość całego procesu.

Potrzebujesz dane ze strony internetowej?

Skontaktuj się z nami już dziś, aby uzyskać spersonalizowaną ofertę dostosowaną do Twoich potrzeb. Nasz zespół ekspertów jest gotowy, aby pomóc Ci w pozyskiwaniu precyzyjnych i aktualnych informacji. Nie czekaj – przyspiesz rozwój swojego biznesu dzięki naszym zaawansowanym usługom web scrapingu!

Usługa Web Scrapingu – czyli pobieranie danych ze stron internetowych

Dlaczego usługa web scrapingu może być przydatna? Przede wszystkim, pozyskiwanie danych w sposób automatyczny pozwala na oszczędność czasu i zasobów. Tradycyjne metody zbierania danych, takie jak ręczne przeszukiwanie stron internetowych, są czasochłonne i podatne na błędy. Web scraping eliminuje te problemy, zapewniając szybkie i dokładne pobieranie danych ze stron internetowych. Dzięki temu firmy mogą skupić się na analizie zebranych informacji i podejmowaniu strategicznych decyzji, zamiast tracić czas na ręczne zbieranie danych.

Ekstrakcja danych ze stron internetowych jest szczególnie cenna w dzisiejszym świecie, gdzie ilość dostępnych informacji jest ogromna i ciągle rośnie. Web scraping umożliwia dostęp do tych danych w uporządkowany sposób, co jest kluczowe dla firm działających w różnych branżach.

W branży e-commerce, web scraping jest używany do monitorowania cen konkurencji, analizowania trendów rynkowych oraz zbierania opinii klientów. Pozyskiwanie danych ze stron internetowych pozwala na bieżąco aktualizować informacje o produktach i usługach, co jest niezbędne do utrzymania konkurencyjności na dynamicznie zmieniającym się rynku. Firmy mogą szybko reagować na zmiany cenowe i dostosowywać swoje strategie marketingowe, co przekłada się na zwiększenie sprzedaży i zadowolenia klientów.

W sektorze finansowym, web scraping jest wykorzystywany do zbierania danych rynkowych, analizowania trendów giełdowych oraz monitorowania informacji o konkurencji. Ekstrakcja danych ze stron internetowych pozwala na szybki dostęp do kluczowych informacji, które są niezbędne do podejmowania świadomych decyzji inwestycyjnych. Firmy finansowe mogą w ten sposób przewidywać zmiany na rynku i lepiej zarządzać swoimi portfelami inwestycyjnymi.

W branży marketingowej, pozyskiwanie danych ze stron internetowych umożliwia analizę kampanii reklamowych, monitorowanie opinii w mediach społecznościowych oraz badanie zachowań konsumentów. Web scraping pozwala na zbieranie danych z różnych platform i źródeł, co daje pełniejszy obraz rynku i pomaga w tworzeniu skuteczniejszych strategii marketingowych. Firmy mogą lepiej zrozumieć potrzeby i preferencje swoich klientów, co przekłada się na bardziej spersonalizowane i efektywne kampanie reklamowe.

W branży nieruchomości, web scraping jest używany do monitorowania ogłoszeń i analizowania trendów na rynku nieruchomości. Pozyskiwanie danych ze stron internetowych pozwala agentom i deweloperom na szybki dostęp do najnowszych ofert i analizę cen w czasie rzeczywistym. Dzięki temu mogą oni lepiej doradzać swoim klientom i podejmować bardziej świadome decyzje inwestycyjne.

Również w sektorze edukacyjnym, ekstrakcja danych ze stron internetowych znajduje swoje zastosowanie. Umożliwia zbieranie informacji o programach nauczania, trendach edukacyjnych oraz opinii studentów. Pozyskiwanie danych ze stron internetowych pomaga instytucjom edukacyjnym lepiej dostosować swoje oferty do potrzeb rynku i zapewnić wyższy poziom kształcenia.

Podsumowując, web scraping to potężne narzędzie, które umożliwia szybkie i efektywne pozyskiwanie danych z internetu. Ekstrakcja danych ze stron internetowych przynosi korzyści firmom z różnych branż, pozwalając na oszczędność czasu, zasobów i zwiększenie konkurencyjności. Dzięki automatyzacji procesu zbierania danych, firmy mogą skupić się na analizie i wykorzystaniu zebranych informacji, co przekłada się na lepsze decyzje biznesowe i większy sukces na rynku.

Często zadawane pytania

Czym jest web scraping i jak działa?

Web scraping to proces automatycznego pobierania danych ze stron internetowych. Działa poprzez skrypty lub narzędzia, które przeszukują strony internetowe, ekstraktują potrzebne informacje i przekształcają je w uporządkowane dane, gotowe do analizy i wykorzystania.

Jakie praktyki web scrapingu stosujecie?

Przy web scrapingu przestrzegamy kilku kluczowych zasad: szanujemy pliki robots.txt na stronach, nie obciążamy nadmiernie serwerów, stosujemy opóźnienia między kolejnymi zapytaniami, a także zachowujemy anonimowość (np. przez używanie serwerów proxy). Te praktyki pomagają unikać prawnych i etycznych problemów oraz zwiększają efektywność scrapowania.

Czy web scraping jest legalny?

Legalność web scrapingu zależy od wielu czynników, w tym od kraju, w którym jest przeprowadzany, celu scrapingu, rodzaju pobieranych danych oraz specyficznych warunków korzystania ze strony internetowej.

Od czego zależy cena web scrapingu?

Cena usług web scrapingu zależy od szeregu czynników, w tym od złożoności i technologii strony internetowej, z której dane mają być pozyskane. Kluczowe elementy wpływające na koszt to m.in. mechanizmy zabezpieczające stronę przed scrapowaniem, takie jak reCAPTCHA, szyfrowanie danych czy dynamiczne ładowanie treści, które mogą wymagać bardziej zaawansowanych narzędzi i metod scrapingu. Ponadto, koszt może wzrosnąć w zależności od ilości i rodzaju danych do zebrania, częstotliwości scrapingu oraz potrzeby używania proxy lub VPN do maskowania IP.

W jakich formatach dostarczacie pozyskane dane?

Dostarczamy pozyskane dane w różnych formatach, dostosowując się do potrzeb klienta. Najpopularniejsze formaty to CSV, XML, XLS, JSON, SQL, które pozwalają na łatwą integrację z różnymi systemami i aplikacjami. Oferujemy także możliwość dostarczenia danych poprzez API, co umożliwia bezpośrednią i bieżącą integrację pozyskanych danych z systemami klienta. Naszym celem jest zapewnienie maksymalnej elastyczności i wygody dla użytkowników końcowych.